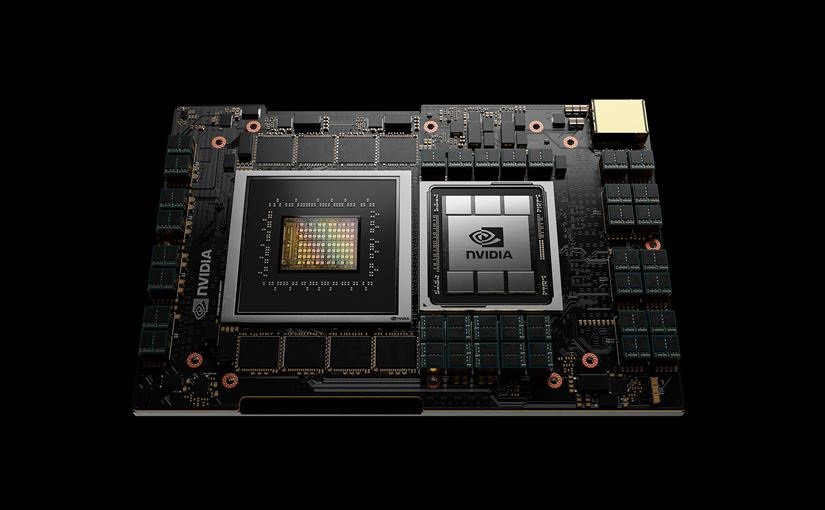

NVIDIAは4月13日、Armベースのプロセッサーとなるデータセンター向けCPU「Grace」を発表した。発売は2023年初頭を予定している。

Graceは、自然言語処理やレコメンダーシステム、AIスーパーコンピューティングなど、「超高速のコンピュータパフォーマンス」と「大容量メモリ」の両方を必要とする膨大なデータセットを分析する、最先端のアプリケーションのコンピューティング要件に対応するように設計された。また、GraceはArm CPUコアと低消費電力のメモリ サブシステムを組み合わせたことで、エネルギー効率に優れた設計によって高いパフォーマンスを実現したという。

NVIDIAにとってのコンピューティングの第3の基盤技術

プレスリリースでは、NVIDIAの創業者/CEOであるジェンスン フアン (Jensen Huang)氏が次のように述べている。

「最先端のAIとデータサイエンスは、現代のコンピューターアーキテクチャの限界を押し広げており、考えられないような大量のデータ処理が可能になっています。ArmのIPライセンシングモデルを使って、NVIDIAは、巨大なスケールのAIとHPCを想定したCPUである、Graceを開発しました。GPUとDPUと組み合わせることで、GraceはNVIDIAにとってのコンピューティングの第3の基盤技術となり、AIを発展させるためにデータセンターを再構築できるようになります。NVIDIAは現在、3種類のチップを提供する企業となりました」

また、ArmのCEOであるサイモンシガース(SimonSegars)氏は次のように話す。

「世界で最も広くライセンスされているプロセッサアーキテクチャとして、Armは日々驚くほどの新たな方法でイノベーションを推進しています。NVIDIAによるGraceデータセンターCPUの発表は、Armのライセンシングモデルがいかに重要な発明を可能にするかを明確に示しています。これは、あらゆる場所のAI研究者や科学者の素晴らしい仕事をさらにサポートするものです」

Graceベースのシステムは、x86 CPUで実行される最先端のNVIDIA DGXベースのシステムよりも10倍速く1兆パラメーターのNLPモデルをトレーニングできるそうだ。このパフォーマンスの根底にあるのは、第4世代のNVIDIA NVLink 相互接続テクノロジであり、NVIDIA Grace CPUとNVIDIA GPUの間で記録的な 900GB/sの接続を提供し、現在の主要サーバーと比較して30倍高い総帯域幅を実現しているという。

>> プレスリリース